EAAA-源码2.0第1页Logstash日志管理系统 v8.19.10Logstash-src-v8.19.10

系统介绍

Logstash是一款功能强大的开源日志与事件数据处理平台,致力于解决分布式系统中应用日志分散、格式不统一、难以集中管理与分析的痛点。作为Elastic Stack(原ELK Stack)生态系统中的核心组件之一,它扮演着“数据搬运工”和“数据加工厂”的关键角色。通过构建从数据源到存储分析中心的自动化流水线,Logstash能够将来自服务器、应用、传感器等多种来源的日志、指标和事件数据进行集中采集、实时解析、深度过滤与灵活转换,最终统一输送至Elasticsearch等存储系统,为后续的可视化分析与监控告警奠定坚实基础,极大地提升了运维效率与问题排查能力。

对于企业和开发者而言,部署Logstash源码意味着可以拥有一个完全自主可控、高度可定制的日志中枢。它不仅仅是简单的日志收集工具,更是一个强大的数据管道框架。用户可以根据自身业务需求,编写或配置丰富的过滤规则,对非结构化的日志文本进行结构化提取,例如从一行访问日志中分离出IP、时间戳、请求方法、状态码、响应时间等关键字段,从而将原始数据转化为易于查询和统计的高价值信息,为企业运维监控、安全审计、业务分析提供强力支持。

核心功能

多源数据采集(Input):支持从极其广泛的来源实时或批量采集数据。内置了数十种输入插件,可以轻松对接文件(File)、系统日志(Syslog)、消息队列(如Kafka、RabbitMQ)、数据库(JDBC)、网络协议(TCP/UDP)、云服务(如AWS CloudWatch)以及各种监控指标(如Beats系列代理)等,为构建统一的数据接入层提供了无限可能。

实时数据解析与过滤(Filter):这是Logstash的核心数据处理环节。它提供了强大的Grok、Dissect等插件,通过正则表达式或分隔符模式匹配,能够将杂乱无章的日志文本精准地解析为结构化的JSON数据。同时,支持使用Mutate插件进行字段增删改、类型转换,用Date插件解析时间戳,用GeoIP插件解析IP地址的地理位置信息,以及用UserAgent插件分析用户代理字符串,实现数据的深度清洗与丰富。

灵活数据输出(Output):经过处理后的数据可以被灵活地路由到不同的目的地。最常用的是输出到Elasticsearch进行索引存储,以便后续通过Kibana进行可视化。此外,也支持输出到其他数据库(如MongoDB、Redis)、消息队列、文件系统、邮件通知或HTTP接口等,满足多样化的下游系统集成需求。

插件化架构与生态:整个系统采用高度模块化和插件化的设计。输入、过滤、输出三大阶段均由独立的插件实现。官方与社区维护了超过200个插件,形成了一个繁荣的生态。用户也可以基于Ruby语言轻松开发自定义插件,以满足特定的业务处理逻辑,实现了极高的扩展性与灵活性。

数据缓冲与可靠性保证:内置的持久化队列(Persistent Queue)功能,可以在数据处理流程中引入磁盘缓冲区。当输出目标(如Elasticsearch)暂时不可用时,数据会安全地暂存在队列中,避免数据丢失,待目标恢复后自动重试发送,确保了数据管道的可靠性与弹性。

集中式配置与监控:支持通过统一的配置文件(通常为logstash.conf)以声明式的方式定义整个数据处理管道。同时,Logstash提供了丰富的监控API和日志输出,允许运维人员实时查看管道的运行状态、处理性能(如事件吞吐量)和插件健康度,便于进行性能调优与故障排查。

Web查询与管理界面(需结合Kibana):虽然Logstash自身主要负责数据处理和传输,但其标准实践是与Kibana紧密结合。处理后的数据存入Elasticsearch后,用户可通过Kibana提供的直观Web界面,进行实时日志搜索、多维统计分析、创建交互式仪表盘和设置监控告警规则,从而实现从数据采集到可视化洞察的完整闭环。

技术特性

Logstash基于JRuby(运行于JVM之上的Ruby实现)开发,巧妙地结合了Ruby语言强大的文本处理与DSL(领域特定语言)能力,以及Java虚拟机(JVM)的跨平台特性和成熟的并发库。其技术架构采用管道(Pipeline)模型,每个管道独立运行,包含输入、过滤、输出三个阶段,阶段之间通过内部队列连接,支持多线程并行处理,有效提升了数据吞吐量。

其配置语言简洁而富有表达力,采用类似Ruby的语法,使得定义复杂的数据处理流程变得非常直观。代码层面,其插件体系设计优雅,遵循一致的接口规范,易于社区贡献和维护。对于源码学习者而言,这是理解大型数据处理框架设计理念和插件化系统实现的优秀范例。项目依赖管理规范,使用Gemfile和Bundler,确保了部署环境的一致性。

运营管理

Logstash的运营管理主要围绕配置管理和运行监控展开。运维人员通过编辑YAML或conf格式的配置文件来定义数据管道,可以管理多个管道以适应不同的数据源和处理逻辑。系统支持配置热重载,在不重启服务的情况下更新管道配置,这对于需要7x24小时运行的生产环境至关重要。

在监控方面,除了查看自身运行日志外,可以启用Logstash的监控API,获取包括JVM内存使用情况、管道事件流入流出速率、队列大小、插件执行耗时等关键指标。这些指标可以推送回Elasticsearch,同样使用Kibana进行监控仪表盘的展示,实现对Logstash集群自身的健康状况和性能表现的集中监控与告警,形成“监控日志系统的系统”的元管理能力。

使用说明

部署Logstash需要Java运行环境(JRE 8或11)。典型的安装方式包括:直接下载官方编译好的压缩包、使用操作系统包管理器(如apt、yum)安装、或通过Docker容器化部署。对于生产环境,推荐使用Docker或配置管理工具(如Ansible)进行自动化部署和版本管理。

基本使用流程为:1) 根据数据源编写输入插件配置;2) 根据日志格式设计Grok等过滤规则,编写过滤插件配置;3) 指定输出目标(如Elasticsearch集群地址),编写输出插件配置。将完整的配置文件置于指定目录后,启动Logstash服务即可开始工作。对于复杂场景,建议先使用`-f`参数指定配置文件进行试运行和调试,确认数据处理逻辑正确后再投入生产。

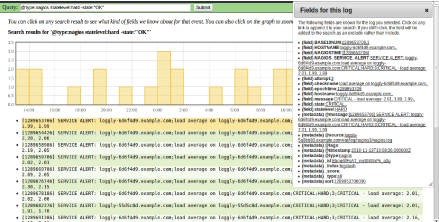

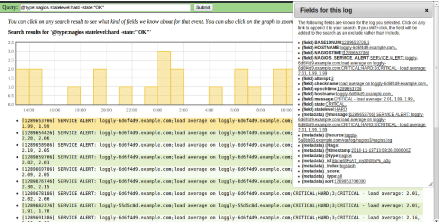

图片演示